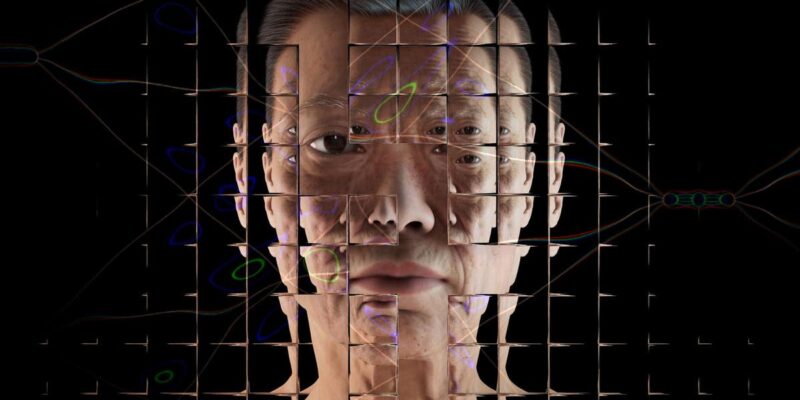

El ex director ejecutivo de Google, Eric Schmidt, ha calificado la inteligencia artificial de tan peligrosa como las armas nucleares.

En su intervención en el Foro de Seguridad de Aspen a principios de esta semana, Eric Schmidt dijo que era “ingenuo sobre el impacto de lo que estábamos haciendo”, pero que la información es “increíblemente poderosa” y “el gobierno y otras instituciones deberían presionar más a la tecnología para que ponga estas cosas en consonancia con nuestros valores.”

“La influencia que tiene la tecnología es muy, muy real. Si pensamos en cómo vamos a negociar un acuerdo sobre la IA, primero hay que contar con tecnólogos que sepan cómo actuar. Primero tienes que tener tecnólogos que entiendan lo que va a pasar, y luego tienes conciencia en el otro lado.

“Digamos que queremos tener una charla con China sobre algún tipo de tratado en torno a las sorpresas de la IA. Muy razonable. ¿Cómo lo haríamos? ¿Quién en el gobierno de EE.UU. trabajaría con nosotros? ¿Y en el lado chino es aún peor? ¿A quién llamamos? … no estamos preparados para las negociaciones que necesitamos.

“En los años 50 y 60, acabamos elaborando un mundo en el que había una regla de “no sorpresa” sobre las pruebas nucleares y finalmente se prohibieron Es un ejemplo de equilibrio de confianza, o de falta de confianza, es una regla de “no sorpresa”.

“Me preocupa mucho que la visión estadounidense de China como corrupta o comunista o lo que sea, y la visión china de Estados Unidos como fracasada… permita a la gente decir ‘Oh, Dios mío, están tramando algo’, y entonces comience algún tipo de enigma… porque te estás armando o preparando, entonces provocas al otro lado”.

Las capacidades de la inteligencia artificial han sido declaradas -y exageradas- en numerosas ocasiones a lo largo de los años. Elon Musk, director ejecutivo de Tesla, ha dicho a menudo que es muy probable que la IA sea una amenaza para los humanos, y recientemente Google despidió a un ingeniero de software que afirmaba que su inteligencia artificial se había vuelto autoconsciente y sensible.

Sin embargo, los expertos han recordado a menudo que la cuestión de la IA es para qué se entrena y cómo la utilizan los humanos. Si los algoritmos que entrenan estos sistemas se basan en datos erróneos, racistas o sexistas, los resultados lo reflejarán.

Comments