La mayoría de las personas no pueden decir que están viendo un video ‘falso’ incluso cuando se les informa que el contenido que están viendo ha sido alterado digitalmente, sugiere una investigación.

El término “deepfake” se refiere a un video donde la inteligencia artificial y el aprendizaje profundo, un método de aprendizaje algorítmico utilizado para entrenar computadoras, se han utilizado para hacer que una persona parezca decir algo que no ha dicho.

Ejemplos notables incluyen un video manipulado del discurso presidencial del Apolo 11 de Richard Nixon y Barack Obama insultando a Donald Trump – con algunos investigadores sugiriendo que el uso ilícito de la tecnología podría convertirla en la forma de crimen más peligrosa en el futuro.

En el primer experimento, realizado por investigadores de la Universidad de Oxford, la Universidad de Brown y la Royal Society, los participantes vieron cinco videos inalterados seguidos de cuatro videos inalterados y un deepfake, y se les pidió a los espectadores que detectaran cuál era falso.

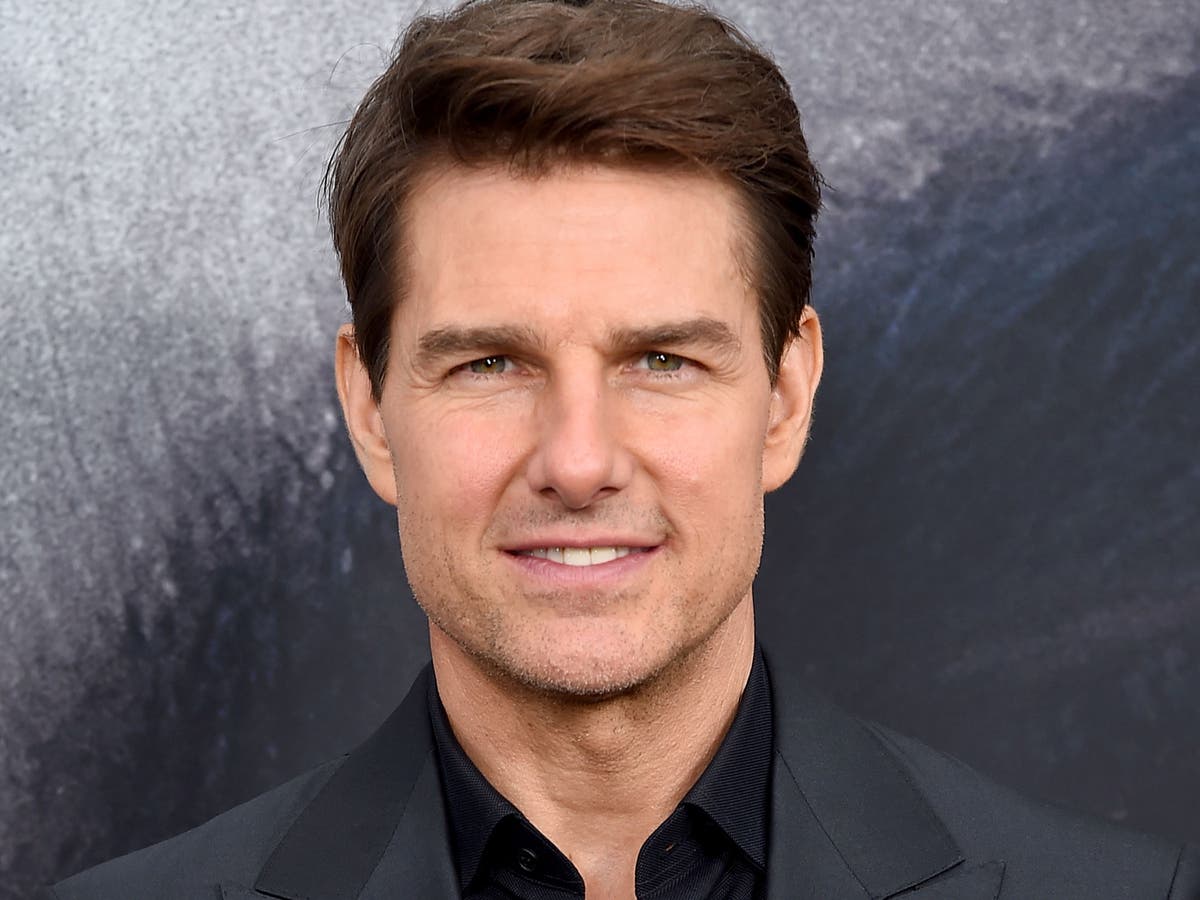

Los investigadores usaron videos de Tom Cruise creados por el artista de efectos visuales Chris Ume, que vieron al actor estadounidense realizar trucos de magia y contar chistes sobre Mikhail Gorbachev en videos subidos a TikTok.

El segundo experimento es igual que el primero, excepto que los espectadores tienen una advertencia de contenido que les dice que uno de los videos será un deepfake.

Los participantes a los que se les emitió la advertencia de antemano identificaron el deepfake en un 20 por ciento en comparación con el diez por ciento que no lo hicieron, pero incluso con una advertencia directa, más del 78 por ciento de las personas no pudieron distinguir el deepfake del contenido auténtico.

“Es probable que las personas no noten nada fuera de lo común cuando se exponen a un video falso profundo de contenido neutral”, escribieron los investigadores en una publicación preliminar del artículo, “en comparación con un grupo de control que solo vio videos auténticos”. Se espera que el documento se publique y sea revisado por pares en unos pocos meses.

Independientemente de la familiaridad de los participantes con el Sr. Cruise, el género, el nivel de uso de las redes sociales o su confianza en poder detectar videos alterados, todos exhibieron los mismos errores.

Los investigadores encontraron que la única característica que se correlaciona significativamente con la capacidad de detectar una falsificación profunda fue la edad, ya que los participantes mayores podían identificar mejor la falsificación profunda.

“La dificultad de detectar manualmente los videos reales de los falsos (es decir, a simple vista) amenaza con reducir por completo el valor de la información de los medios de video”, predicen los investigadores.

“A medida que las personas internalicen la capacidad de engañar de los deepfakes, racionalmente depositarán menos confianza en todos los videos en línea, incluido el contenido auténtico”.

Si esto continúa en el futuro, las personas tendrán que confiar en las etiquetas de advertencia y la moderación del contenido en las redes sociales para garantizar que los videos engañosos y otra información errónea no se vuelvan endémicos en las plataformas.

Dicho esto, Facebook, Twitter y otros sitios dependen de forma rutinaria de que los usuarios normales señalen el contenido a sus moderadores, una tarea que podría resultar difícil si las personas no pueden diferenciar la información errónea del contenido auténtico.

Facebook en particular ha sido criticado repetidamente en el pasado por no brinda suficiente apoyo a sus moderadores de contenido y no eliminar el contenido falso. La investigación en la Universidad de Nueva York y la Université Grenoble Alpes de Francia encontró que desde agosto de 2020 hasta enero de 2021, los artículos de proveedores conocidos de información errónea recibieron seis veces más me gusta, acciones e interacciones que los artículos de noticias legítimos.

Facebook sostuvo que dicha investigación no muestra la imagen completa, ya que “el compromiso [with Pages] no debe… confundirse con la cantidad de personas que realmente lo ven en Facebook”.

Los investigadores también expresaron su preocupación de que “dichas advertencias pueden descartarse como políticamente motivadas o sesgadas”, como lo demuestran las teorías de conspiración que rodean a la vacuna COVID-19 o el etiquetado de Twitter de los tuits del expresidente Trump.

El 15 por ciento de las personas en Estados Unidos creía que el deepfake antes mencionado del presidente Obama llamando al entonces presidente Trump un “total y completo imbécil” era exacto. un estudio de 2020, a pesar de que el contenido en sí es “altamente improbable”.

Una desconfianza más general de la información en línea es un posible resultado tanto de las falsificaciones profundas como de las advertencias de contenido, advierten los investigadores, y “los legisladores deberían tomar medidas”. [that] en cuenta al evaluar los costos y beneficios de moderar el contenido en línea”.

Comments