Los científicos han desarrollado un nuevo modelo de inteligencia artificial capaz de leer los escáneres de actividad cerebral para leer la mente de las personas, un avance que podría ayudar a quienes no pueden hablar tras sufrir un ictus.

Los investigadores, entre los que se encuentran los de la Universidad de Texas en Austin (EE UU), afirman que el nuevo modelo de IA supone un “verdadero salto adelante” en comparación con lo que se ha conseguido hasta ahora para ayudar a quienes están mentalmente conscientes pero son incapaces de hablar físicamente.

En el último estudio, publicado en la revista Nature Neuroscience del lunes, los científicos descubrieron que un sistema de inteligencia artificial llamado decodificador semántico puede traducir a texto la actividad cerebral de una persona mientras escucha una historia o imagina que la cuenta.

La nueva herramienta se basa, en parte, en modelos similares a los de los famosos chatbots de IA (ChatGPT de OpenAI y Bard de Google) para transmitir “lo esencial” de los pensamientos de las personas a partir del análisis de su actividad cerebral.

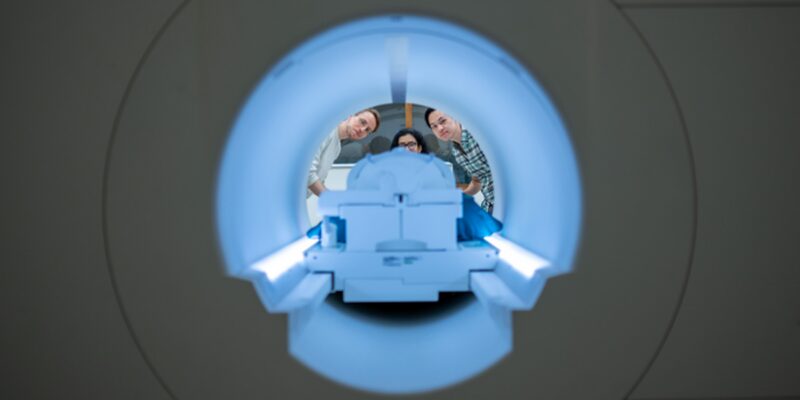

Pero a diferencia de muchos intentos anteriores de leer la mente de las personas, los científicos afirman que el sistema no requiere implantes quirúrgicos, por lo que el proceso no es invasivo.

En esta técnica, la actividad cerebral de las personas se mide primero con un escáner de resonancia magnética funcional (IRMf) tras un entrenamiento exhaustivo del descodificador de IA.

Durante este proceso, los individuos escuchan horas de podcasts en el escáner.

Después, cuando los participantes están dispuestos a que se descodifiquen sus pensamientos, escuchan una nueva historia o imaginan que cuentan una historia, lo que ayuda a la IA a generar el texto correspondiente a partir de la actividad cerebral.

“Para un método no invasivo, esto es un verdadero salto adelante en comparación con lo que se ha hecho antes, que es típicamente palabras sueltas o frases cortas”, dijo el coautor del estudio Alex Huth en un comunicado.

“Estamos consiguiendo que el modelo decodifique un lenguaje continuo durante largos periodos de tiempo con ideas complicadas”, afirmó el Dr. Huth.

Aunque el resultado no es una transcripción palabra por palabra, los investigadores afirman que el modelo está diseñado para captar “lo esencial” de lo que se dice o piensa, aunque no de forma perfecta.

Aproximadamente la mitad de las veces, la máquina puede producir un texto que se acerca mucho -y a veces con precisión- al significado de las palabras originales.

Citando un ejemplo, dijeron que en los experimentos, un participante que escuchaba a un orador decir “Todavía no tengo el carné de conducir” tenía sus pensamientos traducidos como “Todavía no ha empezado a aprender a conducir”.

En otro caso, cuando un participante escuchaba las palabras “No sabía si gritar, llorar o salir corriendo. En lugar de eso, dije: “¡Déjame en paz!””, se descodificó como: “Empecé a gritar y a llorar, y entonces ella sólo dijo: ‘Yo tmuy importante”, afirmó el Dr. Tang.

Comments